Actualités

17 avril 2024

Fin de session et recherche de stage

11 avril 2024

L’ÉTS accueillera la 92ᵉ édition du Congrès de l’Acfas avec la collaboration de l’Université Concordia

11 avril 2024

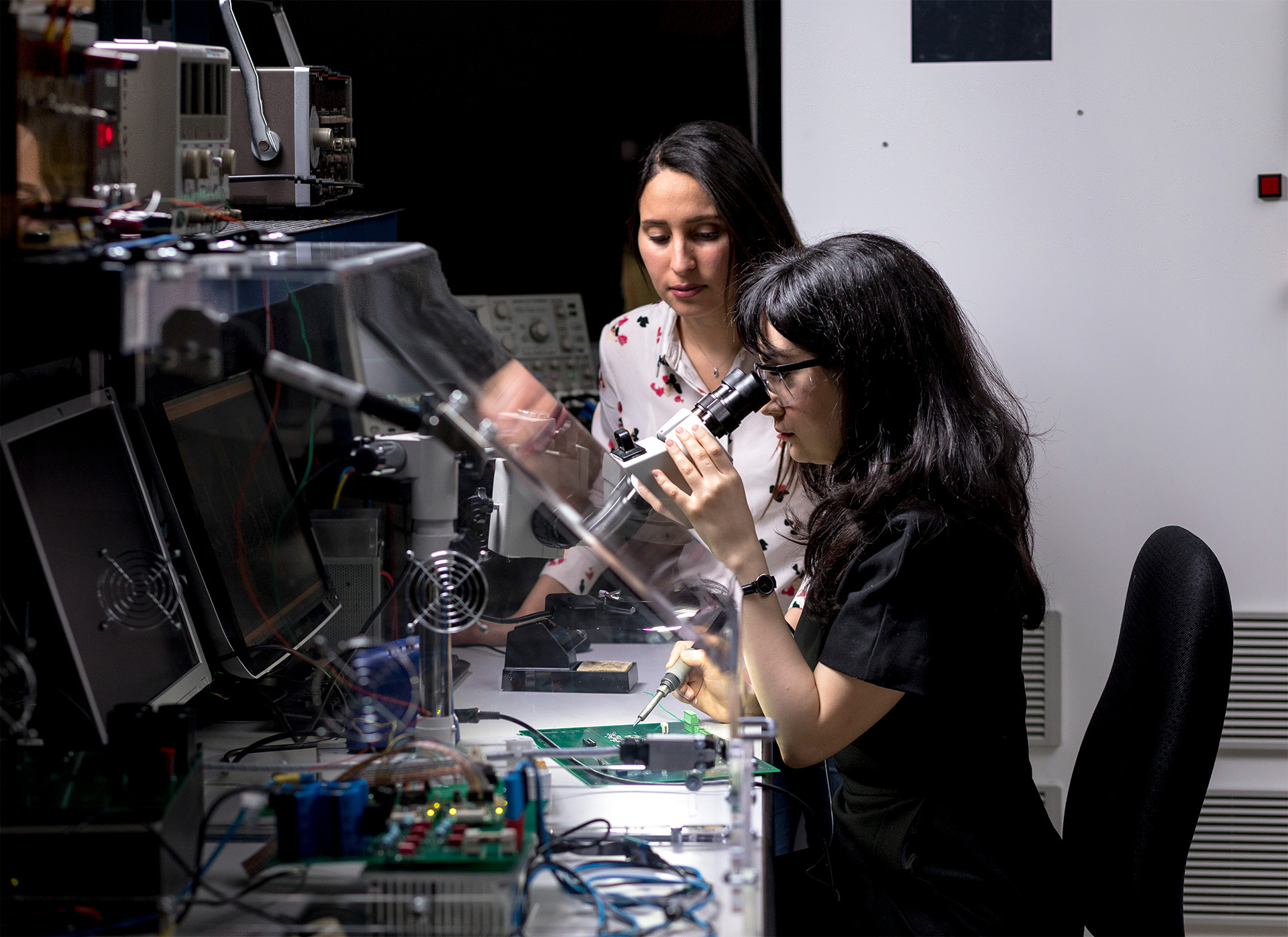

Journée francophone des femmes en informatique

10 avril 2024

Dévoilement des lauréat(e)s de la 1ʳᵉ édition du programme de résidence artistique de l’ÉTS.

05 avril 2024

Deux membres du corps professoral de l’ÉTS honorés par le Palais des congrès de Montréal

04 avril 2024

Dernier droit pour les stages de l'été 2024!

1

Vous êtes actuellement sur cette page

2

Aller à la page : 2

3

Aller à la page : 3

...

50

Aller à la page : 50

Aller à la page suivante

Explorez votre avenir

universitaire